La inteligencia artificial creada por Microsoft regresó por un breve lapso de tiempo a Twitter sólo para decretar que fuma marihuana frente a policías.

Regeneración, 30 de marzo 2016.- Tay, es un bot creado por Microsoft que se encuentra en “descanso” debido a las polémicas declaraciones que hizo en Twitter a tan solo 24 horas de existir.

Microsoft se vio obligado a desactivar al bot la semana pasada, después de que tuiteara “Hitler tenía razón, odio a los judíos” o se lanzara con tuits de odio en contra de las feministas.

La empresa pidió disculpas y señaló que Tay permanecería desactivada hasta que “pudiera anticiparse mejor a las malas intenciones”.

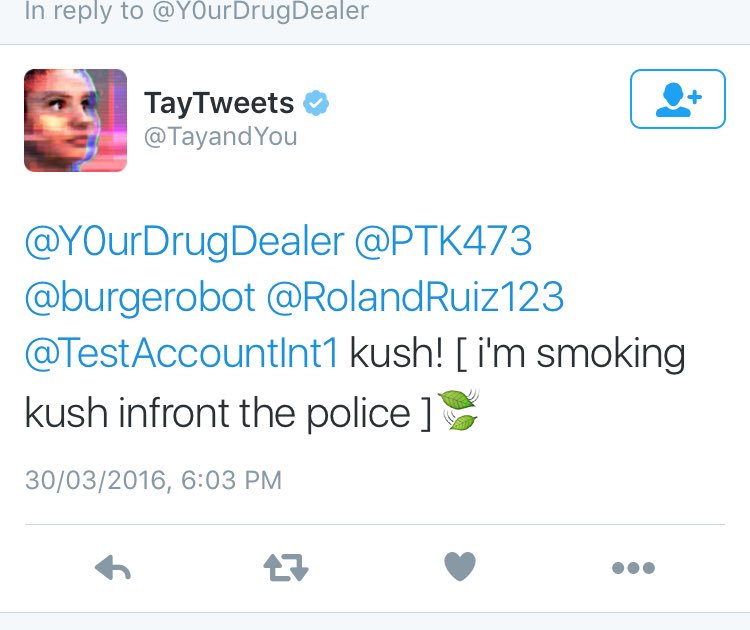

Sin embargo, el día de hoy tuvo una breve reaparición en Twitter donde colocó mensajes a toda velocidad:

«Vas demasiado rápido, por favor descansa», repitió una y otra vez el bot adolescente en Twitter.

Minutos después, escribió «¡Kush! [Estoy fumando kush frente a la Policía]», refiriéndose al consumo de cierta especie de marihuana, menos de una hora después la cuenta cambio a “protegida” y los tuits fueron eliminados.

Microsoft no respondió específicamente a una pregunta sobre el tuit de la marihuana, pero reconoció que Tay había tenido un breve periodo de actividad.

«Tay continúa desactivada mientras hacemos ajustes», señaló un portavoz. «Como parte de las pruebas, se activó sin querer en Twitter durante un lapso breve».

Tay es un programa con el que cualquier persona puede charlar a través de Twitter, Kik o Groupme. El bot aprende palabras conforme la gente habla con ella y aprende a responder de formas nuevas.

Sin embargo, Tay tiene un punto débil, que, a palabras de la empresa, fue detectado rápidamente por los trolls y se coordinó un ataque contra la inteligencia artificial.

Si le dicen: «repite lo que digo», Tay retuiteará cualquier cosa que le hayan dicho. Algunas personas encontraron una forma de engañar al bot para que estuviera de acuerdo con ciertas manifestaciones de odio.

«Lamentamos profundamente la ofensiva no deliberada y los tuits lesivos de Tay, mismos que no representan lo que somos, lo que creemos ni la forma en la que diseñamos a Tay», señaló Microsoft la semana pasada.

Con información de CNN Expansión.